Een efficiënte aanpak van online haatspraak vereist het voorkomen dat ze überhaupt kan circuleren op sociale media. De regels ontmoedigen Big Tech vandaag echter nog te veel om voor de preventieve aanpak te kiezen. Maar waar anticiperende sociale media een deel van de oplossing zijn, brengt het ook ernstige gevaren met zich mee.

De Amerikaanse auteur Roxane Gay had gelijk toen ze sociale media een 'dubbelsnijdend zwaard' noemde.1 Op zijn best geeft het gemarginaliseerde of onderdrukte groepen de mogelijkheid om los van enig officieel kanaal hun mening te delen, informatie te zoeken en in contact te komen met lotgenoten. Het moet niet verbazen dat autoritaire regimes wel vaker sociale media proberen te blokkeren als protesten de kop opsteken, zoals nu in Myanmar naar aanleiding van de coup door het leger. Op zijn slechtst, en helaas al te vaak, zijn sociale media een platform van scheldtirades, haat en belaging. Nu we meer dan ooit gekluisterd zitten aan onze schermen voor menselijk contact en interactie, worden we ook gevoeliger en afhankelijker van wat er via sociale media onze huiskamer binnenkomt.

Enkele recente voorbeelden geven pijnlijk duidelijk de gevaarlijke impact van sociale media aan. In januari benam een dertienjarig meisje zich het leven omdat intieme foto's van haar via sociale media werden gedeeld.2 De Belgische format van het programma Big Brother koos onlangs voor een blackout van haar sociale media door de constante stroom van haat.3 Facebook erkende zelf de cruciale rol die het platform speelde in het geweld tegen de Rohingya in Myanmar.4 Het platform werd maandenlang gebruikt om haat te zaaien tegen deze minderheid. In de VS konden Donald Trump, zijn aanhangers en allerhande conspiracy theorists op Twitter jarenlang tegenstanders demoniseren en bedreigen, met de bestorming van het Capitool als dieptepunt van de Amerikaanse samenleving. Deze op zich los van elkaar staande feiten – veraf of dichtbij – zijn beklijvende voorbeelden van de rol die sociale media kan spelen in het aanzetten tot haat en geweld. De strijd tegen online haatspraak staat dan ook hoog op de agenda bij overheden en sociale media.

In antwoord hierop kijken overheden naar sociale media als poortwachters van wat er op hun platformen verschijnt. Dit leidt tot de ongemakkelijke vaststelling dat quasi ongenaakbare privébedrijven beslissen over welke meningen wel en niet gezien mogen worden. Bovendien wordt van sociale media steeds meer verwacht dat ze er ook voor zorgen dat illegale of schadelijke posts worden verwijderd nog voor iemand het ziet of zelfs voorkomen. Deze 'private censuur' botst met de vrijheid van drukpers en informatie, en met de vrije meningsuiting. Hoe vinden we een evenwicht tussen het bestrijden van haatspraak en de bescherming van vrije meningsuiting in een online wereld? De Europese Commissie publiceerde onlangs haar voorstel voor een nieuwe richtlijn die elektronische diensten, zoals sociale media, moet regelen. Deze bijdrage stelt zich de vraag of deze richtlijn de juiste antwoorden biedt op de huidige uitdagingen.

VERANTWOORDELIJKHEID VAN TECHBEDRIJVEN: NOTICE AND TAKEDOWN

De vraag naar de rol van sociale media om haatspraak en andere fenomenen van online geweld te bestrijden, hangt samen met hun aansprakelijkheid voor de content die op hun platformen wordt gepost. Voor de bestraffing van strafbare meningen voorziet de Belgische grondwet een cascadesysteem waarbij de uitgever, de drukker of de verspreider enkel bestraft kan worden als de auteur niet gekend is. Vertaald naar sociale media, kan een platform pas aangesproken worden als de verspreider van de post niet gekend is. De aansprakelijkheid van sociale media wordt verder beperkt door de Europese regels in de e-handel richtlijn voor passieve hostingdiensten.5 Dit zijn diensten die zelf geen content generen, maar louter een platform zijn waarop hun gebruikers tekst, foto's of filmpjes plaatsen. Op het eerste zicht zijn sociale media dus volstrekt passief ten aanzien van de mogelijks haatdragende en schadelijke content. Voor deze bedrijven geldt dat ze in principe niet aansprakelijk zijn voor de content die op hun platformen worden geplaatst en geen verplichting hebben om die content actief te monitoren. Slechts als ze op de hoogte worden gebracht van mogelijks schadelijke of illegale content, moeten ze dit zo snel mogelijk bekijken en verwijderen.

Deze zogenaamde notice and takedown verplichting was lange tijd de basis voor sociale media om online haatspraak te benaderen. Slechts in de mate dat een post gemeld werd en hun moderatoren dit beoordeelden als in strijd met de toepasselijke wetten of de gebruikerspolicy van het bedrijf, werd content verwijderd. Daardoor bleef veel schadelijke content online omdat het niet gemeld werd. Bovendien bleek de reactie tegen dergelijke content vaak te traag. Pas nadat moderatoren de content hebben beoordeeld, wordt deze verwijderd. Tijdens die periode wordt een bericht gemakkelijk duizenden keren gedeeld en gedownload. Bijgevolg verwerden sociale media tot vrijplaatsen voor haat, belaging, bedreiging en contramine. De sociale media zelf schermden lange tijd met het belang om de vrijheid van meningsuiting en informatie te beschermen.

Deze passieve houding bleek steeds minder houdbaar door de ingrijpendere impact van sociale media op de offline wereld. Zo haalde Italië in januari nog TikTok offline toen een tienjarig meisje verhangen bleek door mee te doen aan een online uitdaging op het sociale medium.6 Bovendien kwam steeds meer kritiek op de voorstelling van sociale media als louter passieve platformen. Door hun niet-transparante algoritmes bepalen ze namelijk welke berichten we al dan niet zullen zien en welke viraal gaan. Op aandringen van overheden, gebruikers en niet het minst van adverteerders werden het gros van de sociale media dan ook responsiever om snel schadelijke content te verwijderen. Tussen 2015 en 2017 schortte Twitter 1,2 miljoen accounts op voor het aanzetten tot of verheerlijken van terrorisme in reactie op de terroristische aanslagen door IS.7 Ook in de strijd tegen kinderpornografie namen sociale media een proactieve houding. Facebook meldde dat 99% van dergelijk materiaal door hen proactief werd verwijderd nog voor het gemeld werd door gebruikers.8 In navolging van de Black Lives Matter beweging en de groeiende dreiging van extreemrechtse complotdenkers in de VS, kwam dan weer de strijd tegen racisme en haatspraak op basis van ras, afkomst of etniciteit onder de aandacht. TikTok communiceerde in de zomer van 2020 dat het alleen al in de VS 380.000 video's en 64.000 reacties verwijderde alsook 1.300 accounts schrapte, omdat deze in strijd waren met hun aangescherpt beleid over het aanzetten tot haat.9

HET HUIDIGE KADER SCHIET TEKORT

De cijfers van sociale media over de verwijderde berichten lijken significant, maar ze zijn nog steeds maar een fractie van het geheel aan schadelijke online content. Sociale media worden verweten dat ze slechts ingrijpen als adverteerders de druk opdrijven en dat hun reactie te traag is om schade te voorkomen of verspreiding tegen te gaan. Hierop ontwikkelden verschillende grote techbedrijven nieuwe technologie, veelal op basis van artificiële intelligentie, om dergelijke content automatisch te detecteren en verwijderen. Sommigen gaan nog een stap verder door technologie te creëren die preventief werkt. Gebruikers kunnen bijvoorbeeld een naaktbeeld aan Facebook bezorgen als ze vrezen dat het beeld verspreid zal worden zonder hun toestemming.10 De technologie achter het platform treedt in werking als een gelijkaardig beeld wordt geüpload en zorgt ervoor dat het nooit publiekelijk verschijnt. Evenzeer is er technologie in de maak die een bericht taalkundig analyseert nog voor het online komt. De gebruiker wordt gewezen op de mogelijke haatdragende of schadelijke content in strijd met de richtlijnen van het platform.11 Dit zou de gebruiker moeten aanzetten tot reflectie.

Waar deze technologieën als best practices tegen online haatspraak naar voor worden geschoven, botsen ze vandaag met het geldende wettelijke kader. Onder de huidige e-handel richtlijn van de EU geldt de uitsluiting van aansprakelijkheid onder het notice and takedown kader enkel voor platformen die passief zijn. Hoe actiever ze ingrijpen bij het verwijderen en sturen van content des te kwetsbaarder ze zich opstellen voor het doorprikken van deze uitsluiting van aansprakelijkheid. Bovendien gaan ver niet alle sociale media mee in deze evolutie om ook proactief content te verwijderen. Sociale media die het minder moeten hebben van adverteerders of juist veel volgers aantrekken door de grenzen van het wettelijke op te zoeken, beperken zich strikt tot een passieve notice and takedown reactie. De EU probeerde het probleem reeds in te dijken door een vrijwillige gedragscode in het leven te roepen waarbij de platformen zich engageerden om sneller schadelijke content te verwijderen en hier transparant over te communiceren.12 Ondanks dat de code en monitoring door de deelnemende sociale media zeker voor een verbetering zorgden, blijkt in de praktijk dat sociale media nog al te vaak weigeren om content te verwijderen na een melding, zelfs al is deze content haatdragend of schadelijk.

In de praktijk blijkt dat sociale media nog al te vaak weigeren content te verwijderen na een melding.

De EU wil dit probleem aanpakken door een nieuw kader te scheppen met de Digitale Diensten Regelgeving (Digital Services Act of DSA) die de e-handel richtlijn moet vervangen.13 De vraag was of de EU in navolging van de VS ook een zogenaamde 'Goede Samaritaan'-bepaling zou invoegen. Die sluit de aansprakelijkheid van platformen uit als zij op eigen initiatief content verwijderen omdat het volgens hen schadelijk, obsceen of gewelddadig is.14 Indien het platform met goede intenties handelde, kunnen zij niet aansprakelijk gesteld worden als een rechtbank later zou oordelen dat de verwijdering een ongeoorloofde inbreuk is van het recht op vrije meningsuiting, informatie of ander recht. De EU lijkt in haar voorstel niet zover te willen gaan.15 Aan het basisprincipe van de e-handel richtlijn wordt niet getornd. De basis voor aansprakelijkheid voor online content van hosting platformen blijft de notice and takedown. Er komt geen verplichting om actief te gaan monitoren en verwijderen. Wel neemt het een mogelijke hindernis daartoe weg door in artikel 6 DSA te voorzien dat hostingdiensten hun uitsluiting van aansprakelijkheid niet verliezen als zij vrijwillig en op eigen initiatief illegale inhoud opsporen, identificeren en verwijderen, of de toegang daartoe onmogelijk maken. Dit moet wel te goeder trouw en diligent gebeuren alsook in lijn met hun eigen gedragsregels.

HET ONMOGELIJK MAAR ONVERMIJDBARE EVENWICHT TUSSEN TE VEEL EN TE WEINIG

De Digitale Diensten Regeling (DSA) moet een nieuwe impuls geven aan de strijd tegen online haatspraak en andere gevaarlijke content. De angst om aansprakelijk gesteld te worden voor schadelijke content alsook de druk van adverteerders en de publieke opinie, zullen deze evolutie verder bestendigen. Toch is dit geen mirakeloplossing. Zoals reeds hoger aangestipt, is er geen enkele verplichting tot actieve monitoring waardoor de buitenbeentjes en rough sites zich kunnen blijven verschuilen achter het passieve karakter van hun platform. Bovendien kiezen steeds meer sociale media ervoor om delen van hun platformen te versleutelen. Hierdoor verdwijnt een groot deel van sociale media achter gesloten deuren waar geen controle of monitoring door het platform meer mogelijk is. De inspanningen die een medium als Facebook doet voor de strijd tegen kinderpornografie dreigen futiel te worden eens het zijn sociale communicatie app Messenger versleutelt, zoals het al enige tijd geleden aankondigde.

Bovendien is een doorgedreven en zelfs proactieve monitoring van online content niet zonder gevaren. In onze rechtsstaat wordt de vrijheid van meningsuiting en informatie beschermd als belangrijk goed voor een goede functionerende democratie. Het Europees Hof voor de Rechten van de Mens benadrukte reeds meermaals dat dit recht niet alleen een bescherming biedt aan informatie of ideeën die beschouwd worden als onschadelijk, maar ook aan deze meningen die de overheid of een deel van de bevolking 'beledigen, choqueren of storen'.16 Nog volgens datzelfde Hof kan het nodig zijn om bepaalde vormen van meningsuiting die aanzetten tot haat te sanctioneren en voorkomen, zij het op voorwaarde dat deze beperkingen of sancties proportioneel zijn en de kern van het recht op vrije meningsuiting niet raken.17 Essentieel hierbij is dat elke beperking aan de vrije meningsuiting gepaard gaat met een rechtsmiddel om hiertegen op te komen.

De beoordeling van een toelaatbare of niet-toelaatbare mening is dus zeker niet evident. Dit speelt minder bij zogenaamde image based content, namelijk online posts van beelden die illegaal of schadelijk zijn en waarbij geen mening wordt geuit, zoals kinderpornografisch materiaal of de verspreiding van naaktbeelden zonder toestemming. Bij online posts met een mening is de grens van het aanvaardbare veel dunner. Waar er reeds veel discussie bestaat over de correcte grenzen in de rechtspraak, geven we vandaag deze beslissingsmacht in grote mate aan sociale media en dus private bedrijven. Indien de regels hen ertoe aanzetten om al te snel posts te verwijderen indien deze mogelijks als storend worden ervaren, dreigt de private censuur de vrije meningsuiting via sociale media te ondergraven. Daarbij komt dat sociale media wereldwijd opereren en dus ook in landen waar overheden dreigen met acties tegen deze platformen die kritische stemmen ongemoeid laten. Vice versa dreigen bepaalde illiberale regimes dan weer met acties tegen sociale media omdat ze te actief haatdragende extreemrechtse of xenofobe content verwijderen of accounts schorsen.18

De Europese Commissie is met de DSA is niet blind voor deze realiteit. Ze erkent de mogelijke dreiging voor vrije meningsuiting bij de poortwachtersrol die sociale media vervullen. Het huidige ontwerp voorziet dan ook in de verplichting dat het verwijderen of onmogelijk maken van de toegang tot content door hosting diensten moet gebeuren met inachtneming van het beginsel van vrijheid van meningsuiting.19 Bovendien is er de suggestie dat de analyse van het evenwicht tussen vrije meningsuiting enerzijds en andere rechten en belangen anderzijds bij de verwijdering een belangrijk criterium zal zijn om te oordelen of het sociale medium 'diligent' optrad en dus aanspraak kan maken op de uitsluiting van aansprakelijkheid.

Als 'datablok' is de EU een voldoende belangrijke markt om regels af te dwingen.

De nieuwe Europese regels zoeken een evenwicht tussen te veel en te weinig. Ook in de aanpak van haatspraak blijken sociale media een dubbelsnijdend zwaard. Hoe dan ook leidt het tot de ongemakkelijke vaststelling dat de zoektocht naar deze balans vandaag grotendeels in handen ligt van privébedrijven waarbij hun belangrijkste belangen veelal niet in Europa liggen. De beoordeling van de beperkingen aan de vrije meningsuiting zijn dan ook niet langer het alleenrecht van de Belgische rechter. Als 'datablok' is de EU echter wel een voldoende belangrijke en aantrekkelijke markt om regels af te dwingen. De Europese rechtbanken en overheden moeten dan ook een dragende en sturende rol spelen om de zoektocht naar het juiste evenwicht te sturen, maar ook om transparantie van de sociale media te eisen alsook (rechts)middelen voor gebruikers bij al te overijverige dan wel lakse platformen.

VOETNOTEN

- R. Gay, 'Justine Sacco's aftermath: The cost of Twitter outrage', Salon, 24/12/ 2013.↑

- 'Meisje (13) maakt eind aan haar leven na online verspreiding expliciete beelden', Het Parool, 16/1/2021.↑

- 'Big Brother heeft genoeg van haatboodschappen: sociale media op zwart', De Standaard, 13/2/2021.↑

- 'Facebook Admits It Was Used to Incite Violence in Myanmar', New York Times, 6/11/2018; 'The country where Facebook posts whipped up hate', BBC, 12/9/2018.↑

- Richtlijn 2000/31/EG van het Europees Parlement en de Raad van 8 juni 2000 betreffende bepaalde juridische aspecten van de diensten van de informatiemaatschappij, met name de elektronische handel, in de interne markt ('Richtlijn inzake elektronische handel'), OJ. L-178, 1 - 16. Deze regels warden omgezet in artikel XII.19 Belgische Wetboek voor Economisch Recht.↑

- 'Italy blocks TikTok for certain users after death of girl allegedly playing 'choking' game', The Guardian, 23/1/ 2021.↑

- D. Reisinger, 'Twitter Has Suspended 1.2 Million Terrorist Accounts Since 2015', Fortune, 5/4/2018. Voor een overzicht van de verschillende social media, zie G. Kalpakis, T. Tsikrika, I. Gialampoukidis, S. Papadopoulos en S. Vrochidis, 'Analysis of Suspended Terrorism-Related Content on Social Media', in G. Leventakis en M.R. Haberfeld (eds.), Community-Oriented Policing and Technological Innovations, Springer, New York, 2018, pp. 107-118↑

- Facebook Community Standards Enforcement Report, November 2019 Edition (13 november 2019), https://about.fb.com/news/2019/11/community-standards-enforcement-report-nov-2019/.↑

- N. Malara en E. Culliford, 'TikTok removes 380,000 videos in U.S. for violating hate speech policy', Reuters, 20/8/2020.↑

- O. Solon, 'Facebook asks users for nude photos in project to combat 'revenge porn'', The Guardian, 7/11/2017.↑

- Hierbij wordt veelal gebruik gemaakt van Natural Language Processing voor de analyse van de tekst. Voor een goed overzicht van de verschillende technieken die sociale media gebruiken of testen voor het filteren, verwijderen of voorkomen van schadelijke content zie G. Sartor en A. Loreggia, The impact of algorithms for online content filtering or moderation (Study requested by the JURI committee of the European Parliament), te raadplegen op: www.europarl.europa.eu/RegData/etudes/STUD/2020/657101/IPOL_STU(2020)657101_EN.pdf.↑

- EU Code of Conduct on illegal online hate speech. Te raadplegen via: https://ec.europa.eu/commission/presscorner/detail/en/IP_16_1937.↑

- Voorstel voor een Verordening van het Europees Parlement en de Raad betreffende een eengemaakte markt voor digitale diensten (wet inzake digitale diensten) en tot wijziging van Richtlijn 2000/31/EG, COM(2020) 825 final 2020/0361(COD).↑

- 47 U.S.C. § 230 Communication Decency Act.↑

- Dit werd wel geopperd als mogelijkheid in een eerdere communicatie: Communication form the Commission to the European Parliament, the Council, the European Economic and Social Committee and the Committee of the Regions on tackling illegal content online - towards an enchanced responsibility of online platforms (Brussel 28 september 2017), COM(2017) 555 final. Voor een kritische beschouwing zie: A. Kuczerawy, 'The good samaritan that wasn't: volunatry monitoring under the (draft) digital services act', Verfassungsblog, 12/1/2021.↑

- De befaamde stelling dat ook meningen die 'offend, shock or disturb' bescherming genieten onder artikel 11 van het Europees Verdrag voor de Rechten van de Mens werd reeds in de jaren '70 bepaald. EHRM 7 december 1976, Handyside v. the United Kingdom, § 49.↑

- EHRM 6 juli 2006, Erbakan v. Turkey, § 56.↑

- 'Poland readies law blocking social media bans', Euractiv Network, 13/1/2021.↑

- Recital 22 DSA bepaalt dat 'removal or disabling of access should be undertaken in the observance of the principle of freedom of expression'.↑

Samenleving & Politiek, Jaargang 28, 2021, nr. 3 (maart), pagina 57 tot 62

HET ONLINE POLITIEKE GEVECHT

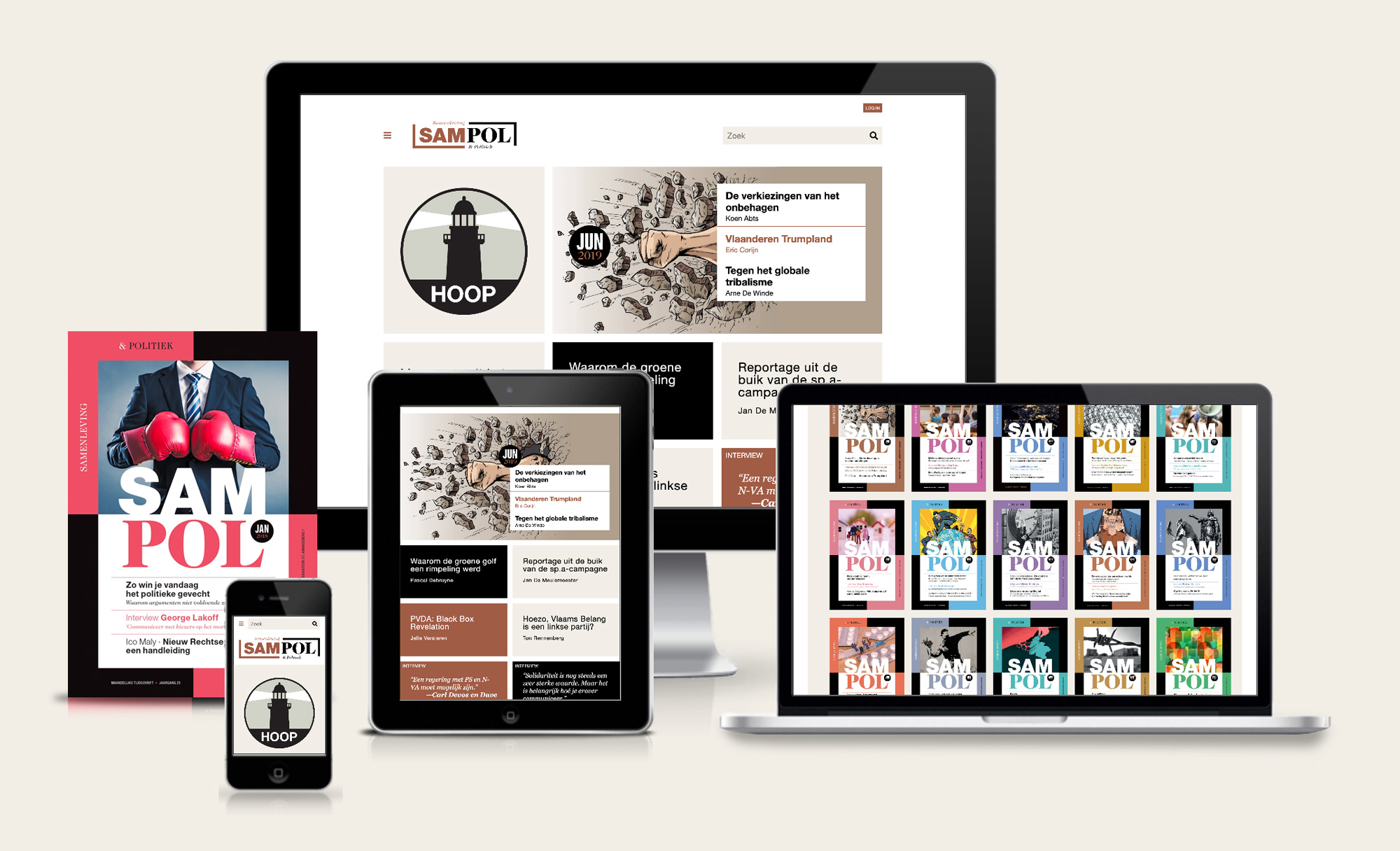

Abonneer je op Samenleving & Politiek

Het magazine verschijnt 10 keer per jaar; niet in juli en augustus.

Proefnummer? Factuur? Contacteer ons via

info@sampol.be

of op 09 267 35 31.

Het abonnementsgeld gaat jaarlijks automatisch van je rekening. Het abonnement kan je op elk moment opzeggen. Lees de

Algemene voorwaarden.

Je betaalt liever via overschrijving?

Abonneren kan ook uit het buitenland.

*Ontdek onze SamPol draagtas.